728x90

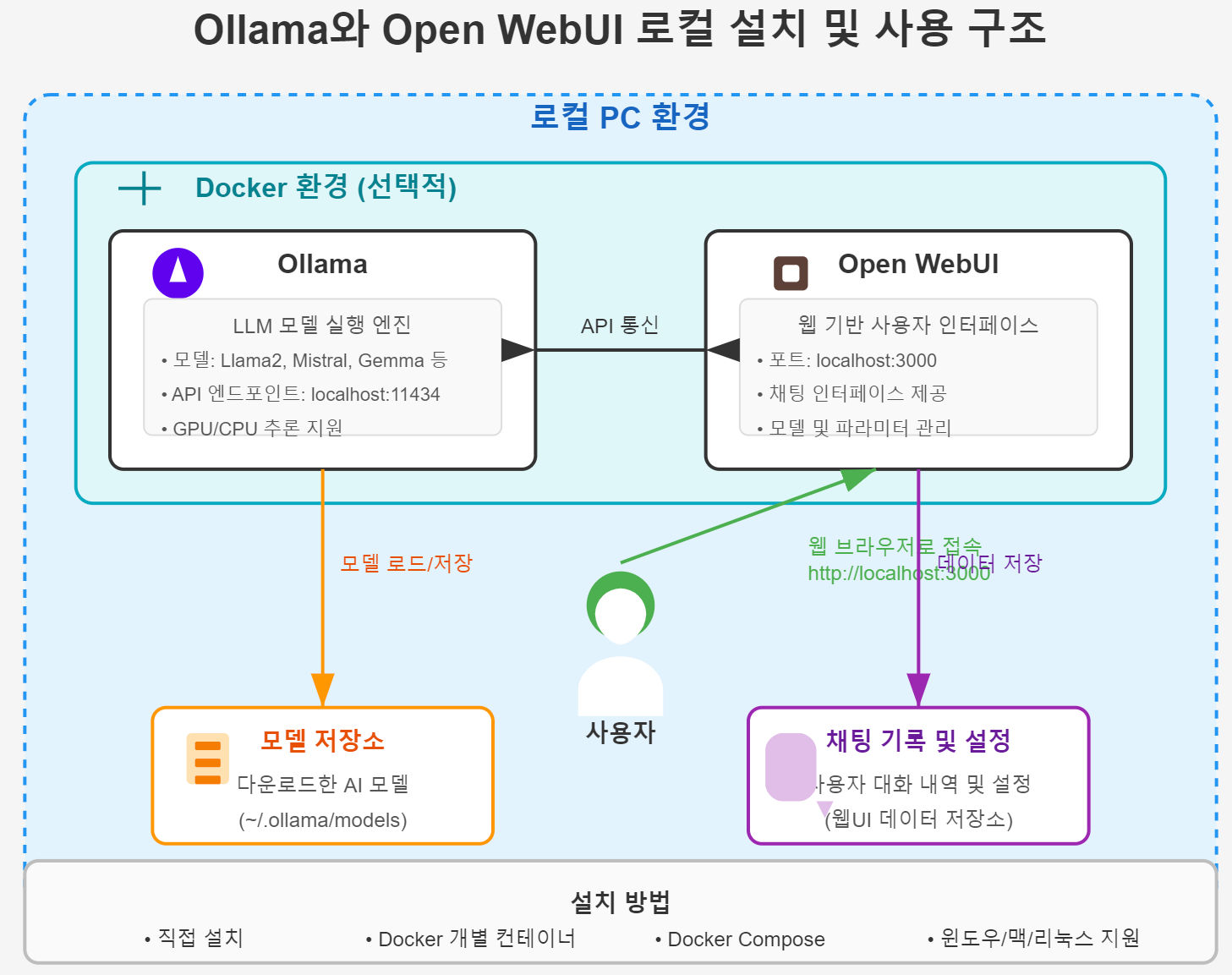

Ollama 및 Open WebUI를 활용한 로컬 PC 설치 및 사용 매뉴얼

이 가이드는 Ollama와 Open WebUI를 로컬 PC에 설치하고 사용하는 방법을 단계별로 안내합니다.

목차

- 준비 사항

- Ollama 설치하기

- Open WebUI 설치하기

- Open WebUI 설정 및 Ollama 연결

- 모델 다운로드 및 사용하기

- 고급 설정 및 기능 활용

- 문제 해결

1. 준비 사항

- 최소 시스템 요구사항:

- CPU: 최신 멀티코어 프로세서 (Intel/AMD)

- RAM: 최소 8GB (16GB 이상 권장)

- 저장공간: 최소 10GB의 여유 공간 (모델 크기에 따라 더 필요할 수 있음)

- OS: Windows 10/11, macOS 10.15+, Linux (Ubuntu 20.04+ 권장)

- GPU: NVIDIA GPU (CUDA 지원) 또는 Apple Silicon (M1/M2/M3) 권장 (선택 사항)

2. Ollama 설치하기

Windows

- Ollama 공식 웹사이트에서 Windows 설치 파일 다운로드

- 다운로드한 설치 파일(.exe)을 실행

- 화면의 지시에 따라 설치 완료

- 설치가 완료되면 시스템 트레이에 Ollama 아이콘이 표시됨

macOS

- Ollama 공식 웹사이트에서 macOS 설치 파일 다운로드

- 다운로드한 .dmg 파일 실행

- Ollama 앱을 Applications 폴더로 드래그하여 설치

- Applications 폴더에서 Ollama 앱 실행

- 메뉴 바에 Ollama 아이콘이 표시됨

Linux (Ubuntu)

# 설치 스크립트 실행

curl -fsSL https://ollama.ai/install.sh | sh

# Ollama 서비스 시작

ollama serve

3. Open WebUI 설치하기

Docker를 이용한 설치 (모든 OS)

- Docker Desktop 설치 (아직 설치하지 않은 경우)

- 터미널 또는 명령 프롬프트를 열고 다음 명령 실행:

docker pull ghcr.io/open-webui/open-webui:latest

docker run -d --name open-webui -p 3000:8080 -v open-webui:/app/backend/data --restart always ghcr.io/open-webui/open-webui:latest

직접 설치 (고급 사용자)

사전 요구사항 설치

설치 과정

# 저장소 클론

git clone https://github.com/open-webui/open-webui.git

cd open-webui

# 백엔드 설치

cd backend

pip install -r requirements.txt

# 프론트엔드 설치

cd ../frontend

npm install

4. Open WebUI 설정 및 Ollama 연결

- 웹 브라우저를 열고 http://localhost:3000 접속 (Docker 설치 시)

- 직접 설치한 경우 백엔드와 프론트엔드를 각각 실행해야 함

- 초기 설정 화면에서:

- 사용자 계정 생성 (이메일, 비밀번호 설정)

- Ollama 연결 설정:

- Ollama 호스트 URL: http://localhost:11434 (기본값)

- API 키: (비워두면 됨, Ollama는 기본적으로 API 키를 요구하지 않음)

- "연결 테스트" 버튼을 클릭하여 Ollama 연결 확인

- 설정 저장

5. 모델 다운로드 및 사용하기

모델 다운로드

- Open WebUI 대시보드에서 "모델" 탭 클릭

- "모델 추가" 버튼 클릭

- 다음 중 원하는 모델 선택:

- Llama2

- Mistral

- Gemma

- CodeLlama

- Phi-2

- 기타 제공되는 모델

- "다운로드" 버튼 클릭하여 선택한 모델 다운로드 시작

- 모델 크기에 따라 다운로드 시간이 다름 (1GB~10GB 범위)

모델 사용하기

- Open WebUI 대시보드에서 "채팅" 탭 클릭

- 새 채팅 시작 ("+" 버튼 클릭)

- 우측 상단에서 사용할 모델 선택

- 프롬프트 입력란에 질문이나 명령 입력

- 전송 버튼 클릭하여 AI와 대화 시작

6. 고급 설정 및 기능 활용

모델 파라미터 설정

- 채팅 화면 우측 상단의 설정 아이콘 클릭

- 다음 파라미터 조정 가능:

- Temperature: 응답의 무작위성 조절 (낮을수록 일관된 응답)

- Top P: 토큰 샘플링 확률 조절

- Max Tokens: 최대 출력 토큰 수

- Context Window: 컨텍스트 창 크기

- System Prompt: 모델의 기본 동작 지정

채팅 기록 관리

- 좌측 사이드바에서 이전 채팅 목록 확인

- 채팅 이름 변경, 삭제, 내보내기 등 관리 가능

- 채팅 폴더 생성하여 대화 정리 가능

추가 기능

- 파일 업로드: 일부 모델은 이미지 파일 분석 지원

- 코드 실행: 코드 블록 자동 인식 및 구문 강조 표시

- API 사용: API 키를 생성하여 외부 애플리케이션에서 Open WebUI 활용 가능

- 다중 사용자: 여러 계정 생성하여 팀원들과 공유 가능

7. 문제 해결

일반적인 문제

- Ollama에 연결할 수 없음

- Ollama가 실행 중인지 확인 (ollama serve 명령 실행)

- 방화벽 설정 확인

- Ollama 호스트 URL이 올바른지 확인

- 모델 다운로드 실패

- 디스크 공간 확인

- 인터넷 연결 확인

- 터미널에서 직접 ollama pull 모델명 명령 시도

- 모델 로딩 오류

- RAM 사용량 확인 (메모리 부족 가능성)

- GPU 드라이버 업데이트 확인 (NVIDIA 사용자)

- Ollama 재시작 시도

- 응답 생성이 너무 느림

- 더 작은 모델 선택 (예: llama2:7b 대신 llama2:7b-chat-q4_0)

- 하드웨어 가속 확인 (CUDA, ROCm, Metal)

- 다른 애플리케이션 종료하여 리소스 확보

로그 확인

- Ollama 로그:

- Windows: %USERPROFILE%\.ollama\logs

- macOS/Linux: ~/.ollama/logs

- Open WebUI 로그 (Docker 사용 시):

- docker logs open-webui

이 매뉴얼이 Ollama와 Open WebUI를 로컬 PC에서 설치하고 사용하는 데 도움이 되길 바랍니다. 더 자세한 정보는 Ollama 공식 문서와 Open WebUI 공식 문서를 참조하세요.

728x90