😲 당신의 PC가 AI 패러다임을 바꿀 준비가 되었나요? LM Studio와 Gemma3로 로컬 AI 혁명 일으키기!

여러분은 클라우드 서비스에 의존하지 않고도 최첨단 AI 모델을 직접 실행할 수 있다는 사실을 알고 계셨나요? 이 가이드에서는 LM Studio와 Google의 강력한 Gemma3 모델을 설치하고 활용하는 방법을 단계별로 알려드립니다. 데이터 프라이버시를 유지하면서 강력한 AI 기능을 손쉽게 활용해보세요!

🚀 로컬 AI 혁명의 시작: 무엇을 배우게 될까요?

이 가이드에서는 다음 내용을 배우게 됩니다:

- LM Studio 설치 및 설정 방법

- Gemma3 모델 다운로드 및 실행하기

- 최적의 성능을 위한 시스템 요구사항 확인하기

- 다양한 NLP 작업에 모델 활용하기

LM Studio는 컴퓨터에서 대형 언어 모델(LLM)을 로컬로 실행할 수 있는 혁신적인 데스크톱 애플리케이션입니다. 여기에 Google의 최신 오픈소스 LLM인 Gemma3를 더하면, 클라우드에 의존하지 않고도 놀라운 텍스트 생성과 이해 능력을 확보할 수 있습니다.

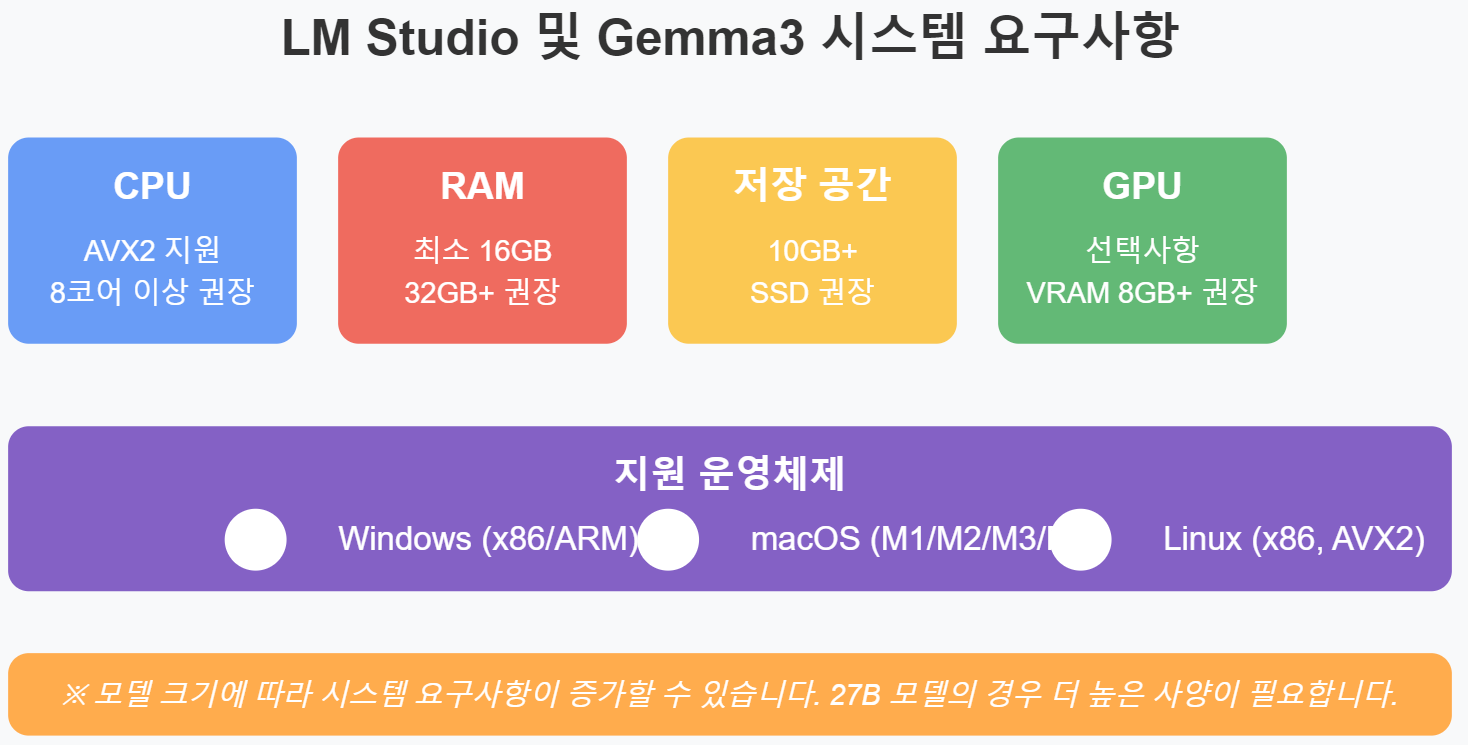

📋 시스템 요구사항: 당신의 컴퓨터가 준비되었나요?

시작하기 전에, 시스템이 요구사항을 충족하는지 확인하세요:

항목 필요 사양 권장 사양

| 운영 체제 | Windows/macOS/Linux | 최신 버전 |

| CPU | AVX2 지원 | 8코어 이상 |

| RAM | 최소 16GB | 32GB 이상 |

| 저장 공간 | 10GB+ | SSD 20GB+ |

| 그래픽 카드 | 선택사항 | VRAM 8GB+ |

🔧 LM Studio 설치 방법: 3단계로 간단하게!

LM Studio 설치는 간단한 몇 단계로 완료됩니다:

- 다운로드: LM Studio 공식 웹사이트에서 운영체제에 맞는 설치 파일을 다운로드합니다.

- 설치 실행:

- Windows: .exe 파일 실행 후 마법사 따라 설치

- macOS: dmg 파일 열고 Applications 폴더에 드래그

- Linux: AppImage 파일을 실행 가능하게 설정 후 실행

- 실행 확인: 애플리케이션을 열어 정상 설치되었는지 확인합니다.

💎 Gemma3 모델 다운로드하기: Google의 최신 AI 모델

Discover 탭에서 직접 다운로드

- LM Studio를 실행하고 Discover 탭으로 이동합니다.

- 검색창에 "gemma3"를 입력합니다.

- 원하는 모델 크기를 선택합니다:

- 1B: 가벼운 모델, 기본적인 작업에 적합

- 4B: 중간 성능, 좋은 균형감

- 12B: 높은 성능, 복잡한 작업 가능

- 27B: 최고 성능, 많은 시스템 자원 필요

- "Download" 버튼을 클릭하여 다운로드를 시작합니다.

- 다운로드가 완료되면 Models 탭에서 모델을 확인할 수 있습니다.

수동 다운로드 방법 (선택 사항)

Discover 탭에서 찾을 수 없거나 특정 버전이 필요한 경우:

- Hugging Face의 unsloth 컬렉션에서 GGUF 파일을 다운로드합니다.

- LM Studio의 Models 탭에서 "Add Model"을 선택합니다.

- 다운로드한 GGUF 파일을 선택합니다.

⚙️ 최적의 설정: Gemma3 성능 극대화하기

모델 성능을 최적화하기 위한 권장 설정은 다음과 같습니다:

설정 항목 권장 값 설명

| Temperature | 1.0 | 창의성 수준, 높을수록 다양한 출력 |

| Top_k | 64 | 다음 토큰 후보 수 |

| Top_p | 0.95 | 확률 분포 임계값 |

| Min_p | 0.0 | 최소 확률 필터링 |

이러한 설정은 LM Studio의 설정 패널에서 쉽게 조정할 수 있습니다. 모델 크기와 시스템 사양에 따라 조정이 필요할 수 있습니다.

🚀 Gemma3 활용하기: 무궁무진한 가능성

모델 설정 후에는 다양한 NLP 작업을 수행할 수 있습니다:

주요 활용 사례

- 텍스트 생성: 창의적인 글쓰기, 콘텐츠 제작

- 질문 답변: 지식 기반 질의응답

- 코드 작성: 프로그래밍 코드 생성 및 설명

- 요약 및 분석: 텍스트 요약 및 정보 추출

- 언어 번역: 다양한 언어 간 번역

🔍 채팅 인터페이스 사용법

모델 실행 후에는 채팅 인터페이스를 통해 다양한 형태의 대화를 진행할 수 있습니다:

- 기본 대화: 일반적인 질문과 답변

- 프롬프트 엔지니어링: 특정 형식의 응답을 유도하는 프롬프트 작성

- 시스템 메시지: 모델의 동작 방식을 지정하는 시스템 메시지 설정

- 대화 저장: 유용한 대화는 저장하여 나중에 참조 가능

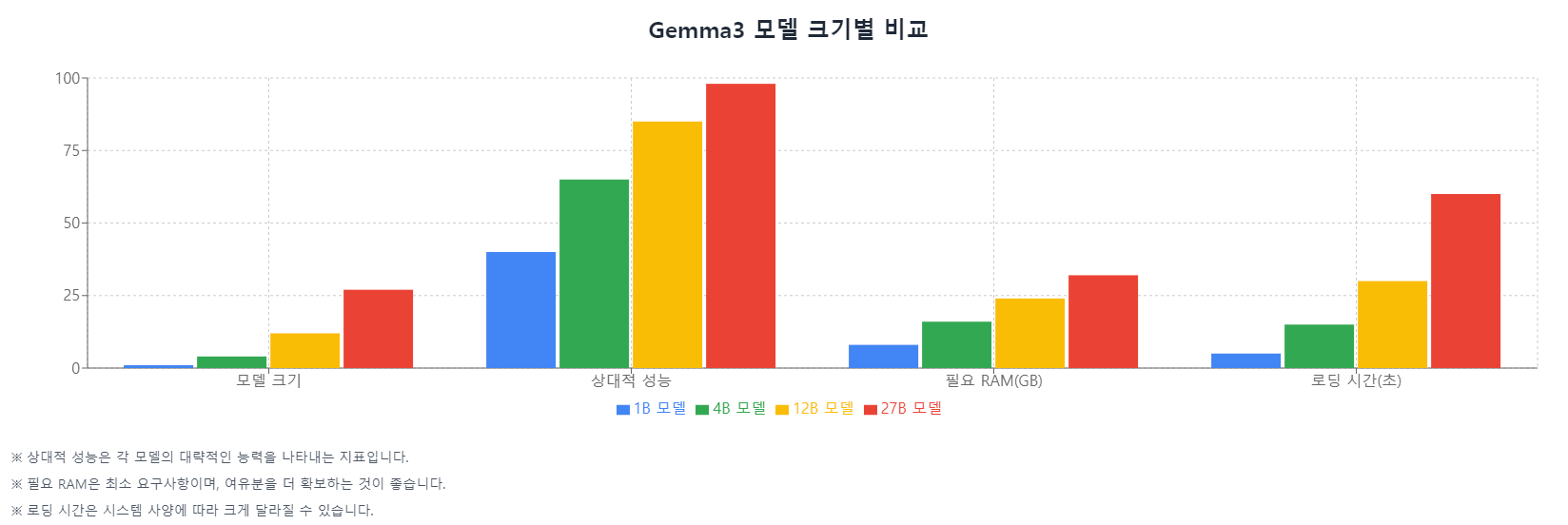

📊 시스템 성능과 모델 크기: 최적의 선택은?

모델 크기에 따른 장단점을 이해하는 것이 중요합니다:

모델 크기 장점 단점 권장 사용 사례

| 1B | 빠른 로딩, 적은 자원 | 제한된 능력 | 간단한 작업, 저사양 PC |

| 4B | 좋은 성능/자원 균형 | 복잡한 작업 제한 | 일반적인 사용, 중간 사양 |

| 12B | 뛰어난 이해력 | 상당한 자원 필요 | 복잡한 작업, 고사양 PC |

| 27B | 최고 수준 성능 | 높은 자원 요구 | 전문적 용도, 최고 사양 |

🔥 문제 해결 및 최적화 팁

모델 실행 중 문제가 발생할 경우 다음 방법을 시도해보세요:

- 메모리 부족:

- 더 작은 모델 사용하기

- 다른 애플리케이션 종료하기

- 시스템 RAM 업그레이드 고려

- 느린 성능:

- GPU 가속 활성화 확인

- Temperature 값 낮추기

- 맥락 길이(Context Length) 줄이기

- 불안정한 실행:

- LM Studio 재시작

- 최신 버전으로 업데이트

- 시스템 드라이버 업데이트

📈 결론: 로컬 AI의 미래가 여기에 있습니다

LM Studio와 Gemma3 모델은 강력한 AI 기능을 로컬에서 활용할 수 있는 획기적인 방법을 제공합니다. 데이터 프라이버시를 유지하면서도 최신 AI 기술의 이점을 누릴 수 있습니다. 이 가이드를 따라 설치하고 AI의 무한한 가능성을 탐험해보세요!

지금 바로 LM Studio를 다운로드하고 Gemma3 모델을 실행하여 로컬 AI 혁명에 동참하세요. 클라우드 의존 없이 강력한 AI 모델을 자유롭게 사용할 수 있는 세상에 오신 것을 환영합니다!

'AI > LM Studio' 카테고리의 다른 글

| "AMD RX 9070 XT 그래픽카드로 LM Studio AI 채팅 성능 최적화 가이드 - 로컬 AI 모델 속도 향상 설정 방법" (0) | 2025.03.15 |

|---|