🧠 Google Gemma 3 - 개발자를 위한 멀티모달 AI 혁명

안녕하세요, AI 기술에 관심 있는 여러분! 오늘은 구글이 최근 공개한 Gemma 3에 대해 심층적으로 알아보려고 합니다. 새로운 오픈 AI 모델이 어떤 혁신을 가져오는지, 왜 개발자들이 주목해야 하는지 함께 살펴봅시다!

💫 Gemma 3란 무엇인가?

Gemma 3는 구글이 공개한 최신 오픈 AI 모델로, Gemini 2.0 기술을 기반으로 개발되었습니다. 가장 주목할 만한 특징은 텍스트와 이미지를 동시에 처리할 수 있는 멀티모달 기능이죠! 더불어 140개 이상의 언어를 지원하고, 개발자의 필요에 맞게 선택할 수 있는 다양한 크기의 모델을 제공합니다.

💡 왜 Gemma 3인가? 구글은 이 모델을 "세계 최고의 단일 가속기 모델"이라고 소개하며, 효율성과 성능을 동시에 강조하고 있습니다.

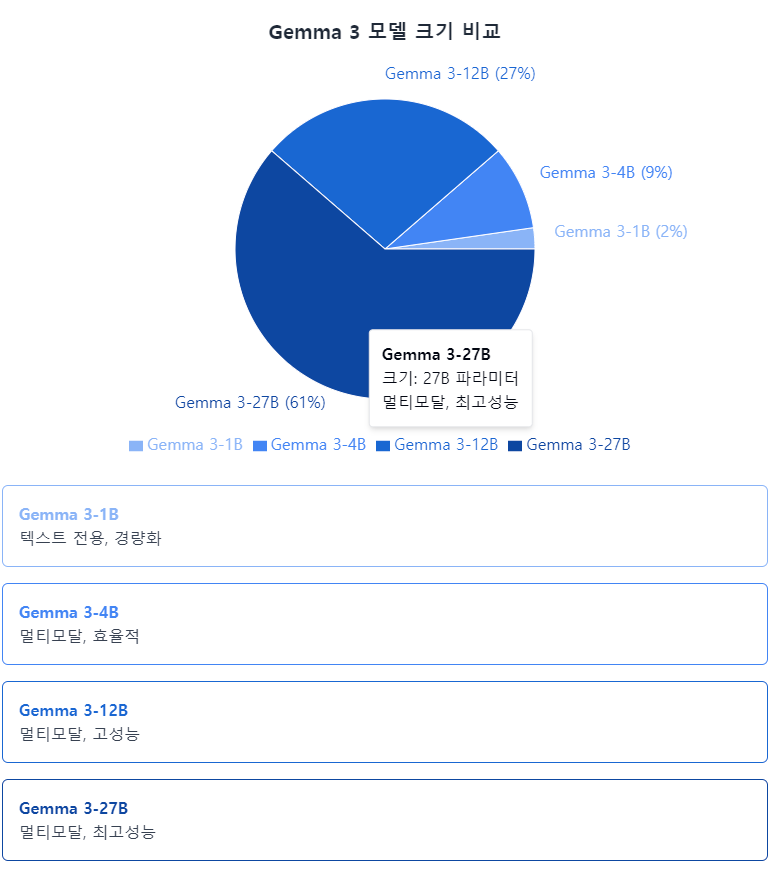

🧩 Gemma 3의 모델 라인업

Gemma 3는 다양한 크기의 모델을 제공합니다:

모델 특징 적합한 용도

| 1B | 텍스트 전용, 경량화 | 기본 텍스트 생성, 리소스 제한 환경 |

| 4B | 멀티모달, 효율적 | 일반 개발 환경, 이미지-텍스트 작업 |

| 12B | 멀티모달, 고성능 | 복잡한 작업, 연구 환경 |

| 27B | 멀티모달, 최고 성능 | 고난도 작업, 엔터프라이즈 환경 |

모델 크기가 커질수록 성능은 향상되지만, 필요한 컴퓨팅 자원도 증가합니다. 여기서 주목할 점은 모든 모델이 단일 가속기(GPU)에 최적화되어 있다는 것! 이는 개인 개발자도 접근하기 쉽게 만들어주죠.

📊 Gemma 3의 장단점 비교

Gemma 3는 다른 AI 모델들과 비교했을 때 어떤 경쟁력을 가지고 있을까요?

✅ 주요 장점

- 멀티모달 처리 능력: 텍스트와 이미지를 자연스럽게 함께 처리

- 다국어 지원: 140개 이상의 언어로 작동

- 효율적인 자원 사용: 단일 GPU에서 최적화된 성능

- 긴 컨텍스트 처리: 128K 토큰의 컨텍스트 윈도우

- 모바일 호환성: 경량화된 모델은 모바일 기기에서도 작동 가능

- 오픈 웨이트: 개발자들이 쉽게 접근하고 수정 가능

❌ 주요 단점

- 라이선스 제한: 완전한 오픈소스는 아님

- 자원 요구량: 큰 모델(27B)은 여전히 고성능 하드웨어 필요

- 잠재적 편향성: 모든 AI 모델이 직면한 문제점

- Google 생태계 의존성: Google Cloud와의 통합에 최적화

🚀 Gemma 3 시작하기

Gemma 3를 직접 사용해보고 싶으신가요? 여기 기본적인 시작 가이드를 준비했습니다!

1. 환경 설정

먼저 필요한 라이브러리를 설치합니다:

pip install transformers

2. 텍스트 모델 로드하기

from transformers import AutoModelForCausalLM, AutoTokenizer

model_name = "google/gemma-3-1b"

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModelForCausalLM.from_pretrained(model_name)

3. 멀티모달 모델 사용하기

from transformers import AutoModelForConditionalGeneration, AutoProcessor

from PIL import Image

# 모델 로드

model_name = "google/gemma-3-4b-it"

processor = AutoProcessor.from_pretrained(model_name)

model = AutoModelForConditionalGeneration.from_pretrained(model_name)

# 이미지와 텍스트 함께 처리

image = Image.open("cat.jpg")

inputs = processor(image, "이 이미지에서 무엇을 볼 수 있나요?", return_tensors="pt")

outputs = model.generate(**inputs)

print(processor.decode(outputs[0]))

4. 텍스트 생성 예제

# 간단한 텍스트 생성

inputs = tokenizer("인공지능의 미래는 어떻게 될까요?", return_tensors="pt")

outputs = model.generate(**inputs, max_length=200)

print(tokenizer.decode(outputs[0]))

🔍 경쟁 모델과의 비교

Gemma 3가 다른 인기 있는 오픈 AI 모델과 어떻게 비교되는지 살펴봅시다:

비교 항목 Gemma 3 Llama 2 Mistral AI

| 멀티모달 기능 | ⭐⭐⭐⭐⭐ | ⭐⭐ | ⭐⭐⭐ |

| 언어 지원 | ⭐⭐⭐⭐⭐ | ⭐⭐⭐ | ⭐⭐⭐⭐ |

| 효율성 | ⭐⭐⭐⭐ | ⭐⭐⭐ | ⭐⭐⭐⭐⭐ |

| 라이선스 자유도 | ⭐⭐⭐ | ⭐⭐ | ⭐⭐⭐⭐ |

| 커뮤니티 지원 | ⭐⭐⭐⭐ | ⭐⭐⭐⭐⭐ | ⭐⭐⭐ |

Gemma 3는 특히 멀티모달 기능과 광범위한 언어 지원에서 강점을 보입니다. Llama 2는 상업적 사용에 제한이 있는 반면, Gemma 3는 상대적으로 유연한 라이선스를 제공합니다. Mistral은 효율성에서 뛰어나지만, 멀티모달 기능에서는 Gemma 3가 우위를 점하고 있습니다.

💡 가장 놀라운 특징: 모바일 AI의 미래

가장 흥미로운 점은 Gemma 3가 모바일 기기에서도 작동 가능하다는 것입니다! Google AI Edge를 통해 개발자들은 스마트폰과 웹 환경에서도 강력한 AI 모델을 구현할 수 있습니다.

이것이 왜 혁신적인지 생각해보세요:

- 오프라인 환경에서도 AI 기능 사용 가능

- 데이터 프라이버시 향상 (데이터가 기기에서 처리)

- 응답 시간 단축 (클라우드 왕복 지연 없음)

- 저비용으로 AI 서비스 배포 가능

🔮 Gemma 3로 할 수 있는 것들

Gemma 3의 실제 응용 사례를 살펴보겠습니다:

- 멀티모달 챗봇: 이미지와 텍스트를 모두 이해하는 고객 서비스 도구

- 콘텐츠 분석 및 생성: 이미지를 분석하고 관련 텍스트 생성

- 다국어 번역 및 요약: 140개 이상의 언어로 작동하는 번역 도구

- 모바일 AI 앱: 오프라인에서도 작동하는 지능형 앱 개발

- 교육용 도구: 다양한 형식의 학습 자료를 이해하고 설명하는 도구

🧠 Gemma 3 활용 팁

Gemma 3를 최대한 활용하기 위한 몇 가지 팁을 공유합니다:

- 적절한 모델 크기 선택: 작업 복잡성과 가용 자원을 고려해 선택

- 프롬프트 엔지니어링: 명확하고 구체적인 지시로 더 나은 결과 얻기

- 파인튜닝 고려: 특정 도메인에 맞게 모델을 조정해 성능 향상

- 배치 처리 활용: 여러 입력을 한 번에 처리해 효율성 높이기

- 모바일 최적화: 경량 모델과 양자화 기법으로 모바일 성능 개선

🌐 더 알아보기

Gemma 3에 대해 더 자세히 알아보고 싶으시다면 다음 자료를 참고하세요:

🔍 결론

Gemma 3는 멀티모달 기능, 효율성, 그리고 모바일 호환성으로 AI 개발 생태계에 신선한 바람을 불어넣고 있습니다. 특히 단일 GPU에 최적화되어 있어 개인 개발자도 쉽게 접근할 수 있다는 점이 큰 매력입니다.

물론 라이선스 제한이나 자원 요구사항 같은 고려 사항이 있지만, Gemma 3는 분명 AI 개발의 미래를 보여주는 중요한 이정표라고 할 수 있습니다. 특히 모바일 기기에서도 작동 가능한 AI의 가능성을 열었다는 점에서 매우 혁신적입니다.

여러분도 Gemma 3를 사용해 보실 생각이 있으신가요? 어떤 프로젝트에 적용해볼 계획인지 댓글로 공유해주세요! 🚀

#구글AI #Gemma3 #멀티모달AI #오픈AI모델 #AI개발 #인공지능 #머신러닝 #개발자도구 #모바일AI #기술블로그

🧠 Google Gemma 3 - 개발자를 위한 멀티모달 AI 혁명

안녕하세요, AI 기술에 관심 있는 여러분! 오늘은 구글이 최근 공개한 Gemma 3에 대해 심층적으로 알아보려고 합니다. 새로운 오픈 AI 모델이 어떤 혁신을 가져오는지, 왜 개발자들이 주목해야 하는지 함께 살펴봅시다!

💫 Gemma 3란 무엇인가?

Gemma 3는 구글이 공개한 최신 오픈 AI 모델로, Gemini 2.0 기술을 기반으로 개발되었습니다. 가장 주목할 만한 특징은 텍스트와 이미지를 동시에 처리할 수 있는 멀티모달 기능이죠! 더불어 140개 이상의 언어를 지원하고, 개발자의 필요에 맞게 선택할 수 있는 다양한 크기의 모델을 제공합니다.

💡 왜 Gemma 3인가? 구글은 이 모델을 "세계 최고의 단일 가속기 모델"이라고 소개하며, 효율성과 성능을 동시에 강조하고 있습니다.

🧩 Gemma 3의 모델 라인업

Gemma 3는 다양한 크기의 모델을 제공합니다:

모델 특징 적합한 용도

| 1B | 텍스트 전용, 경량화 | 기본 텍스트 생성, 리소스 제한 환경 |

| 4B | 멀티모달, 효율적 | 일반 개발 환경, 이미지-텍스트 작업 |

| 12B | 멀티모달, 고성능 | 복잡한 작업, 연구 환경 |

| 27B | 멀티모달, 최고 성능 | 고난도 작업, 엔터프라이즈 환경 |

모델 크기가 커질수록 성능은 향상되지만, 필요한 컴퓨팅 자원도 증가합니다. 여기서 주목할 점은 모든 모델이 단일 가속기(GPU)에 최적화되어 있다는 것! 이는 개인 개발자도 접근하기 쉽게 만들어주죠.

📊 Gemma 3의 장단점 비교

Gemma 3는 다른 AI 모델들과 비교했을 때 어떤 경쟁력을 가지고 있을까요?

✅ 주요 장점

- 멀티모달 처리 능력: 텍스트와 이미지를 자연스럽게 함께 처리

- 다국어 지원: 140개 이상의 언어로 작동

- 효율적인 자원 사용: 단일 GPU에서 최적화된 성능

- 긴 컨텍스트 처리: 128K 토큰의 컨텍스트 윈도우

- 모바일 호환성: 경량화된 모델은 모바일 기기에서도 작동 가능

- 오픈 웨이트: 개발자들이 쉽게 접근하고 수정 가능

❌ 주요 단점

- 라이선스 제한: 완전한 오픈소스는 아님

- 자원 요구량: 큰 모델(27B)은 여전히 고성능 하드웨어 필요

- 잠재적 편향성: 모든 AI 모델이 직면한 문제점

- Google 생태계 의존성: Google Cloud와의 통합에 최적화

🚀 Gemma 3 시작하기

Gemma 3를 직접 사용해보고 싶으신가요? 여기 기본적인 시작 가이드를 준비했습니다!

1. 환경 설정

먼저 필요한 라이브러리를 설치합니다:

pip install transformers

2. 텍스트 모델 로드하기

from transformers import AutoModelForCausalLM, AutoTokenizer

model_name = "google/gemma-3-1b"

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModelForCausalLM.from_pretrained(model_name)

3. 멀티모달 모델 사용하기

from transformers import AutoModelForConditionalGeneration, AutoProcessor

from PIL import Image

# 모델 로드

model_name = "google/gemma-3-4b-it"

processor = AutoProcessor.from_pretrained(model_name)

model = AutoModelForConditionalGeneration.from_pretrained(model_name)

# 이미지와 텍스트 함께 처리

image = Image.open("cat.jpg")

inputs = processor(image, "이 이미지에서 무엇을 볼 수 있나요?", return_tensors="pt")

outputs = model.generate(**inputs)

print(processor.decode(outputs[0]))

4. 텍스트 생성 예제

# 간단한 텍스트 생성

inputs = tokenizer("인공지능의 미래는 어떻게 될까요?", return_tensors="pt")

outputs = model.generate(**inputs, max_length=200)

print(tokenizer.decode(outputs[0]))

🔍 경쟁 모델과의 비교

Gemma 3가 다른 인기 있는 오픈 AI 모델과 어떻게 비교되는지 살펴봅시다:

비교 항목 Gemma 3 Llama 2 Mistral AI

| 멀티모달 기능 | ⭐⭐⭐⭐⭐ | ⭐⭐ | ⭐⭐⭐ |

| 언어 지원 | ⭐⭐⭐⭐⭐ | ⭐⭐⭐ | ⭐⭐⭐⭐ |

| 효율성 | ⭐⭐⭐⭐ | ⭐⭐⭐ | ⭐⭐⭐⭐⭐ |

| 라이선스 자유도 | ⭐⭐⭐ | ⭐⭐ | ⭐⭐⭐⭐ |

| 커뮤니티 지원 | ⭐⭐⭐⭐ | ⭐⭐⭐⭐⭐ | ⭐⭐⭐ |

Gemma 3는 특히 멀티모달 기능과 광범위한 언어 지원에서 강점을 보입니다. Llama 2는 상업적 사용에 제한이 있는 반면, Gemma 3는 상대적으로 유연한 라이선스를 제공합니다. Mistral은 효율성에서 뛰어나지만, 멀티모달 기능에서는 Gemma 3가 우위를 점하고 있습니다.

💡 가장 놀라운 특징: 모바일 AI의 미래

가장 흥미로운 점은 Gemma 3가 모바일 기기에서도 작동 가능하다는 것입니다! Google AI Edge를 통해 개발자들은 스마트폰과 웹 환경에서도 강력한 AI 모델을 구현할 수 있습니다.

이것이 왜 혁신적인지 생각해보세요:

- 오프라인 환경에서도 AI 기능 사용 가능

- 데이터 프라이버시 향상 (데이터가 기기에서 처리)

- 응답 시간 단축 (클라우드 왕복 지연 없음)

- 저비용으로 AI 서비스 배포 가능

🔮 Gemma 3로 할 수 있는 것들

Gemma 3의 실제 응용 사례를 살펴보겠습니다:

- 멀티모달 챗봇: 이미지와 텍스트를 모두 이해하는 고객 서비스 도구

- 콘텐츠 분석 및 생성: 이미지를 분석하고 관련 텍스트 생성

- 다국어 번역 및 요약: 140개 이상의 언어로 작동하는 번역 도구

- 모바일 AI 앱: 오프라인에서도 작동하는 지능형 앱 개발

- 교육용 도구: 다양한 형식의 학습 자료를 이해하고 설명하는 도구

🧠 Gemma 3 활용 팁

Gemma 3를 최대한 활용하기 위한 몇 가지 팁을 공유합니다:

- 적절한 모델 크기 선택: 작업 복잡성과 가용 자원을 고려해 선택

- 프롬프트 엔지니어링: 명확하고 구체적인 지시로 더 나은 결과 얻기

- 파인튜닝 고려: 특정 도메인에 맞게 모델을 조정해 성능 향상

- 배치 처리 활용: 여러 입력을 한 번에 처리해 효율성 높이기

- 모바일 최적화: 경량 모델과 양자화 기법으로 모바일 성능 개선

🌐 더 알아보기

Gemma 3에 대해 더 자세히 알아보고 싶으시다면 다음 자료를 참고하세요:

🔍 결론

Gemma 3는 멀티모달 기능, 효율성, 그리고 모바일 호환성으로 AI 개발 생태계에 신선한 바람을 불어넣고 있습니다. 특히 단일 GPU에 최적화되어 있어 개인 개발자도 쉽게 접근할 수 있다는 점이 큰 매력입니다.

물론 라이선스 제한이나 자원 요구사항 같은 고려 사항이 있지만, Gemma 3는 분명 AI 개발의 미래를 보여주는 중요한 이정표라고 할 수 있습니다. 특히 모바일 기기에서도 작동 가능한 AI의 가능성을 열었다는 점에서 매우 혁신적입니다.

여러분도 Gemma 3를 사용해 보실 생각이 있으신가요? 어떤 프로젝트에 적용해볼 계획인지 댓글로 공유해주세요! 🚀

'GCP' 카테고리의 다른 글

| Gemini CLI 완벽 가이드: 설치부터 인증, Google Cloud 프로젝트 설정까지 (0) | 2025.07.01 |

|---|---|

| 구글의 AI 혁명: Gemma 3를 중심으로 한 LLM 모델 비교 분석 및 시각화 가이드 (0) | 2025.03.14 |

| 구글 클라우드 플랫폼(GCP) 개요 (0) | 2025.03.11 |